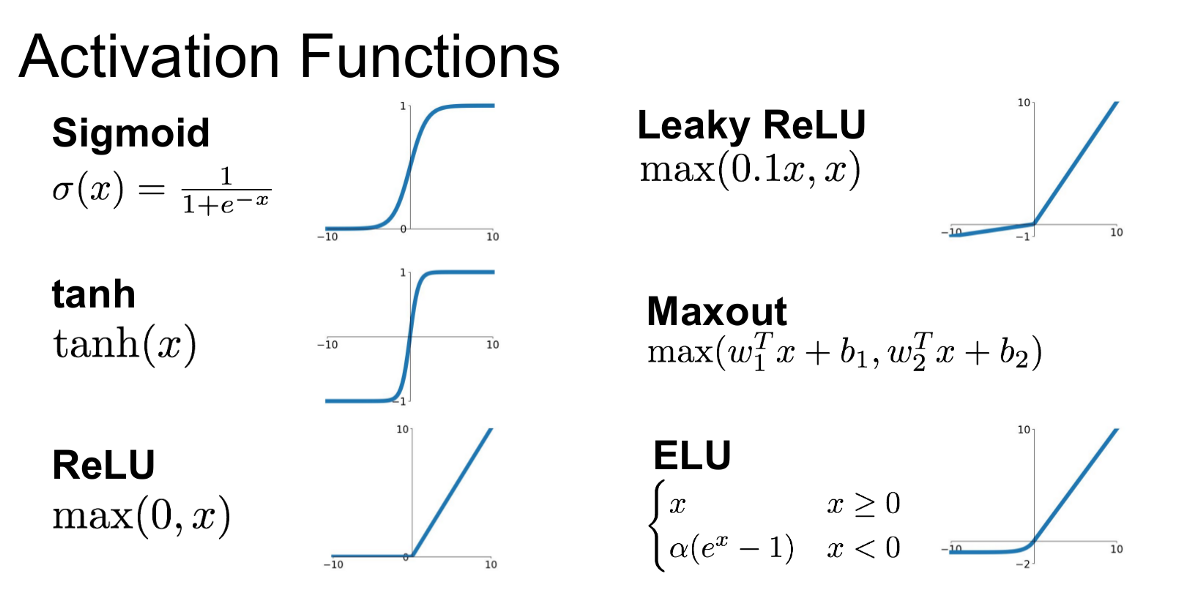

- sigmoid: 로지스틱 회귀분석과 유사, 0~1의 확률값을 가짐

- softmax: 표준화지수 함수. 출력값이 여러개로 주어지고 목표치가 다범주인 경우, 각 범주에 속할 posterior 를 제공.

- ReLU: 0 이하를 0으로 보정. 최근 딥러닝에 많이 사용

- Leaky ReLU: dead ReLU 문제 보정, 0 이하일 때 매우 작은 기울기 부여 (ReLU 가 학습하는 동안 일부 뉴런이 0만을 출력하며 학습되지 않는 문제로, 가중치가 업데이트되다가 음수가 되는 순간 ReLU 로 0으로 변환되어 출력되어 발생)

- Hyperbolic Tangent: -1~1의 확률값을 가짐, sigmoid 와 달리 0 중심, sigmoid 보다 반환값 변화폭이 크며 기울기 소실 문제가 적음

인공신경망(ANN)에서 입력값을 받아 출력값을 계산하는 함수. 인공신경망의 비선형성을 추가하고, 복잡한 패턴을 학습할 수 있게 도와줍니다.

- activation function 예제

- 시그모이드 함수 (Sigmoid Function)

- 하이퍼볼릭 탄젠트 함수 (Hyperbolic Tangent Function)

- 렐루 함수 (Rectified Linear Unit, ReLU)

- Leaky ReLU

- 소프트맥스 함수 (Softmax Function)